W końcu usiadłem do ostatniego klocka w układance zwanej backupy – backup offsite, w tym przypadku w mitycznej chmurze.

Długi czas próbowałem się z backblaze, ale jako że moje dane mają lecieć z NAS, jako zbiorczego punktu, trzeba było używać Backblaze B2, co jakbym nie liczył wychodziło drogo.

Dzięki Tomashowi poznałem pCloud, europejską “chmurę”, stosującą się do europejskiego prawa i uregulowań GDPR a nie kolejne amerykańskie korpo robiące co chce (i przy okazji liżące dupę trumpowi). Z okazji World Backup Day w bdb promocji kupiłem na razie 1TB w opcji lifetime – jednorazowa płatność i gotowe.

Chwilę się mocowałem jak wrzucić rClone na NAS od synology – czy jakaś vm i podmontować zasoby do niej, kolejny kontener? Ale w sumie chyba najprostsze rozwiązanie jest najlepsze: po prostu instalacja pakietu rclone z repozytorium SynoCommunity

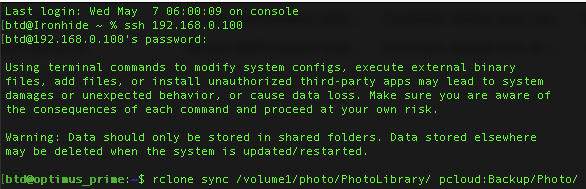

Potem już tylko wbicie po ssh, konfiguracja remote dla pcloud która wymaga pobrania tokena w opcji “nie mam przeglądarki www na hoście” – wszystko jest opisane w manualu rClone.

Pierwszy backup jest prosty jak puszczenie komendy:

rclone sync /volume1/photo/PhotoLibrary/ pcloud:Backup/Photo/a stworzenie harmonogramu to dodanie tej komendy do harmonogramu w gui synology.

[edit]

Jednak nie takie proste 😀

rclone walczy z problemem z timeoutami i wielowątkowym zapisywaniem dużych plików na pcloud, w pakiecie w wersji 1.69.1-1 trzeba pokombinować z opcjami i użyć:

rclone sync --skip-links --transfers 1 --multi-thread-streams 0 /volume1/photo/PhotoLibrary/ pcloud:Backup/Photo/Podobno jest naprawione w wersji 1.69.2, tylko nie widzę na razie pakietu dla synology.